Carian Suara Google

Google adalah salah satu pelopor penyelidikan AI dan banyak projek mereka terus berubah. AlphaZero dari Google Fikiran Dalam pasukan adalah kejayaan dalam penyelidikan AI, kerana kemampuan program untuk belajar permainan rumit dengan sendirinya (Tanpa Latihan dan Intervensi Manusia). Google juga telah berjaya Program Pemprosesan Bahasa Asli (NLP), yang merupakan salah satu sebab di sebalik kecekapan Pembantu Google dalam memahami dan memproses pertuturan manusia.

Google baru-baru ini mengumumkan pembebasan tiga yang baru GUNAKAN modul pelbagai bahasa dan menyediakan lebih banyak model multibahasa untuk mengambil teks yang serupa secara semantik.

Dua modul pertama menyediakan model pelbagai bahasa untuk mengambil teks yang serupa secara semantik, satu dioptimumkan untuk prestasi pengambilan dan yang lain untuk kepantasan dan penggunaan memori yang lebih sedikit. Model ketiga khusus untuk pengambilan jawapan-soalan dalam enam belas bahasa (USE-QA) dan mewakili aplikasi USE yang sama sekali baru. Ketiga-tiga modul multibahasa dilatih menggunakan a kerangka dwi pengekod berbilang tugas , serupa dengan model USE yang asli untuk bahasa Inggeris, sambil menggunakan teknik yang kami kembangkan untuk meningkatkan dual-encoder dengan pendekatan softmax margin aditif . Mereka dirancang bukan hanya untuk mengekalkan prestasi pembelajaran pemindahan yang baik, tetapi untuk melaksanakan tugas pengambilan semantik dengan baik.

Pemprosesan bahasa dalam sistem telah berjalan jauh, dari penghuraian pokok sintaks asas hingga model persatuan vektor besar. Memahami konteks dalam teks adalah salah satu masalah terbesar dalam bidang NLP dan Universal Sentence Encoder menyelesaikannya dengan menukar teks dalam vektor dimensi tinggi, yang menjadikan pemeringkatan dan denotasi teks lebih mudah.

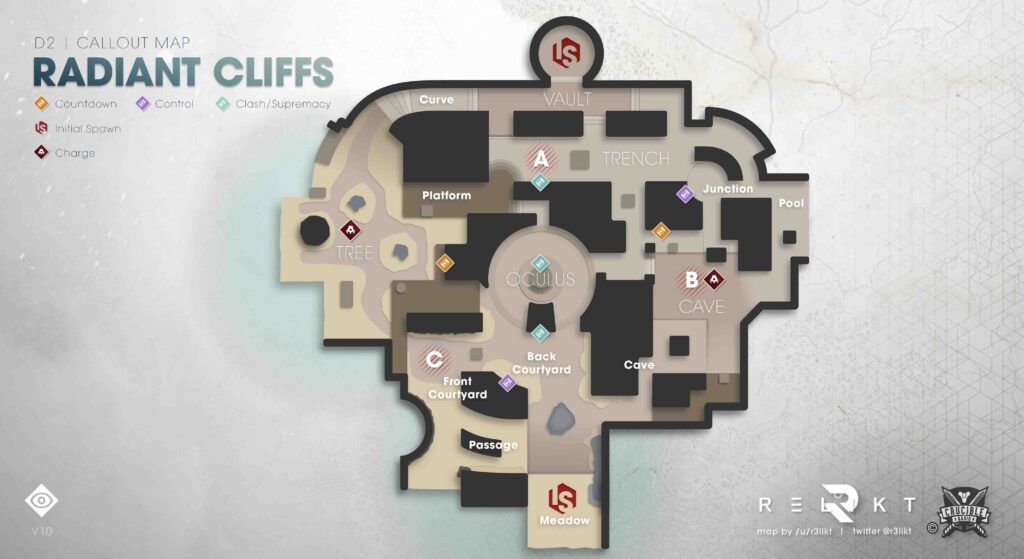

Sumber Struktur Penandaan UTE - Blog Google

Menurut Google, “ Ketiga modul baru semuanya dibina berdasarkan seni bina pengambilan semantik, yang biasanya membagi pengekodan soalan dan jawapan menjadi rangkaian saraf yang terpisah, yang memungkinkan untuk mencari antara berbilion jawapan berpotensi dalam milisaat. Dengan kata lain, ini membantu pengindeksan data yang lebih baik.

' Ketiga-tiga modul multibahasa dilatih menggunakan a kerangka dwi pengekod berbilang tugas , serupa dengan model USE yang asli untuk bahasa Inggeris, sambil menggunakan teknik yang kami kembangkan untuk meningkatkan dual-encoder dengan pendekatan softmax margin aditif . Mereka dirancang bukan hanya untuk mengekalkan prestasi pembelajaran pemindahan yang baik, tetapi untuk melaksanakan tugas pengambilan semantik dengan baik . ' Fungsi Softmax sering digunakan untuk menjimatkan kuasa komputasi dengan mengeksponen vektor dan kemudian membahagikan setiap elemen dengan jumlah eksponen.

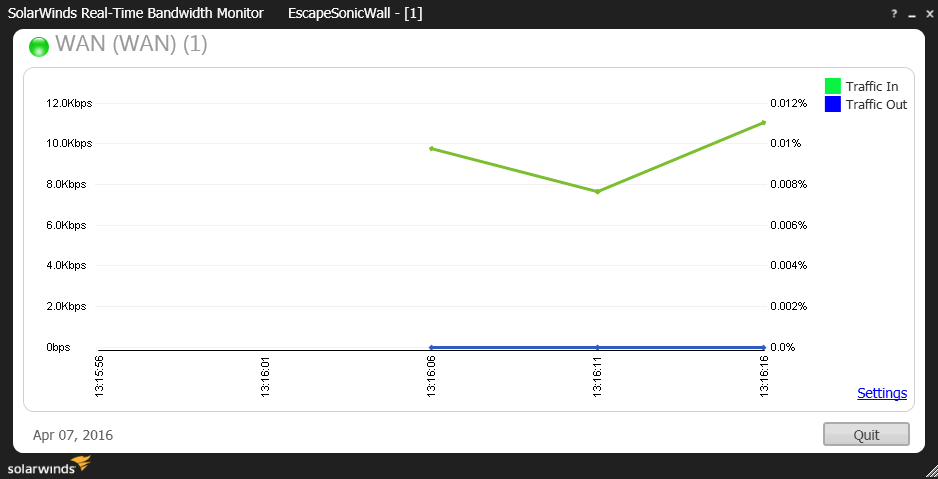

Senibina pengambilan semantik

'Ketiga modul baru semuanya dibangun berdasarkan arsitektur pengambilan semantik, yang biasanya membagi pengekodan pertanyaan dan jawapan menjadi rangkaian saraf yang terpisah, yang memungkinkan untuk mencari antara miliaran kemungkinan jawaban dalam milidetik. Kunci untuk menggunakan pengekod ganda untuk pengambilan semantik yang cekap adalah dengan mengekodkan semua jawapan calon untuk pertanyaan input yang diharapkan dan menyimpannya dalam pangkalan data vektor yang dioptimumkan untuk menyelesaikan masalah jiran terdekat , yang membolehkan sebilangan besar calon dicari dengan cepat dengan baik ketepatan dan ingat semula . '

Anda boleh memuat turun modul ini dari TensorFlow Hub. Untuk bacaan lebih lanjut, rujuk GoogleAI penuh blogpost .

Teg google